インテリジェンスの偏向は技術ではなく倫理の問題です。

人工知能(AI)が人間の判断を代替する時代が到来しています。スマートフォンカメラの顔認識から自動運転車、医療診断、採用評価まで、AIはすでに人々の生活に深く入り込んでいます。しかし、AIの判断が常に公正とは限りません。開発者でさえ意識していない「データ偏向」が特定の性別や人種、年齢層に不利な結果をもたらす事例が続いています。

この問題の根本的な原因は技術ではなく「データ」にあります。AIは学習データを基に世界を理解します。しかし、そのデータが偏っていたり、同意なしに収集された場合、結果も歪められることは避けられません。この問題を解決するために、日本のソニーグループの研究機関であるソニーAI(Sony AI)が新しい基準を提案しました。

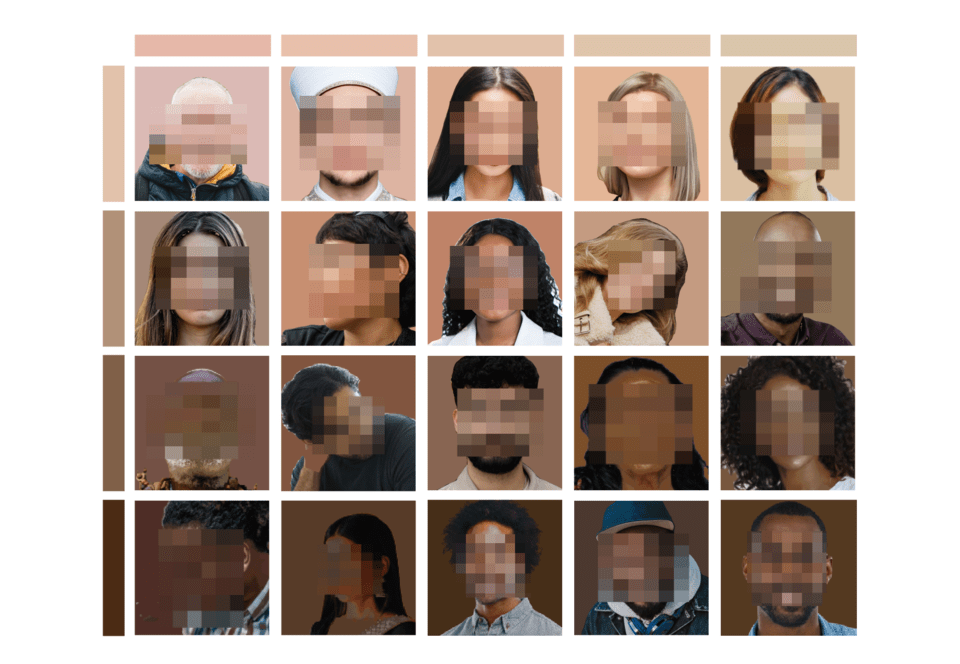

5日(現地時間)、ソニーAIは人工知能偏向問題を解決するための世界初の「公正性データセット」である公正な人間中心イメージベンチマーク(Fair Human-Centric Image Benchmark, FHIBE・フィビー)を公式に発表しました。FHIBEはAIが人の顔や身体を認識する過程で発生する差別的なエラーを点検し、改善できるように設計された新しい基準です。

世界初の「同意基盤・グローバル多様性」データセット

FHIBEはこれまで公開されたどのデータセットよりも徹底的に倫理的手続きを経ました。まずすべての写真は参加者の明確な同意の下で撮影されました。81カ国から1,981人が参加し、合計10,318枚の画像を提供しました。彼らは人種、性別、年齢、髪型、肌の色、文化圏など多様な背景を持つ人物たちです。

ソニーAIは単純に顔写真を集めるだけでなく、各写真には撮影環境、照明、カメラ設定など細部の条件が綿密に記録されました。研究者たちはこのデータを利用してAIモデルが特定の条件でどのような偏向を示すのかを精密に分析できます。例えば、照明が暗い環境で特定の肌色を認識できない場合や、長髪の人より短髪の人をより正確に認識するかどうかなどを把握できます。

FHIBEの開発過程は科学専門ジャーナル『ネイチャー(Nature)』にも掲載されました。該当論文はFHIBEが既存の偏向検証データセットよりもはるかに詳細で実証的な分析を可能にすると評価しました。

「AIは人の想像力を拡張すべきであり、偏見を拡大してはならない」

ソニーグループのAIガバナンス総括でソニーAIのAI倫理責任研究員であるアリス・シャン(Alice Xiang)は今回のプロジェクトを「AI倫理の転換点」と表現しました。

彼は「AI産業は長い間、同意なしに収集された非多様的なデータを使用してきた」とし、「その結果、AIが社会の不平等をそのまま再現したり、深化させたりする問題が生じた」と指摘しました。そして「FHIBEは責任あるデータ収集が実際に可能であることを証明した事例」とし、「情報提供同意、個人情報保護、公正な報酬、安全性、多様性などすべての倫理原則を実際に適用した」と述べました。

ソニーAIのマイケル・シュプランガー(Michael Spranger)代表も「AI技術が人間の想像力を拡張する道具になるにはまず信頼を得なければならない」とし、「FHIBEは公正性と透明性を基にしたAI開発の第一歩」と述べました。

データの偏向、髪の長さでも明らかに

ソニーAIの研究陣はFHIBEを活用して興味深い結果を確認しました。 일부 AI モデルが 「She/Her/Hers」 대명사를 사용하는 사람들을 인식할 때 정확도가 낮았던 것이다. 原因を分析したところ、髪のスタイルの多様性が認識率に大きく影響していることが明らかになりました. 長髪と短髪、カールの度合いにより顔認識の結果が異なり、これはこれまでの公正性 연구では 거의 다뤄지지 않았던 요소でした.

またAIに「この人の職業は何ですか?」といった中立的な質問をした場合、 일부 モ델는 특정 인종や 성별을 범죄 행위나 낮은 사회적 지위와 연관짓는 答변을 내놓기도 했다。FHIBE는 이러한 미묘한 편향까지 진단할 수 있도록 설계되었습니다。

このようにしてFHIBE는 단순に 정확도를 높이기 위한データセットではなく、AIが人間を見つめる「視線」そのものを点検できるツールという点で意義が大きいです。

倫理的収集、透明な管理…AIデータの新基準